()2月24日 消息:据曝光的一份京东内部邮件显示,京东已经开始了“百亿补贴”的内测工作。邮件表示,为了更好地体验“百亿补贴”,京东向内部员工提供优先体验机会,并为发现系统漏洞的员工们设置了特别奖励。

iOS15在线照片翻译功能能否代替专业翻译软件?

顺晟科技

2021-07-23 10:14:58

262

声明:本文来自微信公众号脑极体(ID: Unity 007),作者:张浩,转载许可发表。

在此之前,iOS15系统更新内置了一个功能,引起了不少关注。就是内置照片翻译。

用户可以直接从照片中选择要翻译的文本,查看翻译结果。据说苹果还更新了翻译模式,提高了翻译效果。

如果几年前神经机器翻译的出现是很多人类翻译的噩梦,那么这个系统内置了翻译照片功能,很多专业翻译软件可能无法入睡。(大卫亚设,北上广深)。

对于像我这样需要经常阅读英语信息的人,应该经常接触pdf文献、照片类内容,并在识别第三方软件照片后进行翻译。如果IOS15可以直接识别图片,为什么不省略几个步骤呢?简直是懒人的福音。

那么问题来了。翻译好不好,重点是“功效”。iOS15的照片翻译能力是否已经强大到可以代替专业翻译软件?辛达雅的中文表达一直是NLP领域的难题,要知道拥有硅谷基因的科技公司能完成真正的中英翻译吗?

本着实践真知的态度,我们准备了各种考试问题,选择口碑和用户数比较突出的适当词典APP,参与水平评价,探索iOS15照片翻译的实际水平。

真心话和大冒险:

照片翻译三步曲

对翻译功能的专业评价不少。各种指标,如短小的文章,都有详细的评价标准和规范,但作为普通用户,我们决定在人们日常使用照片翻译的具体场景和阶段进行评价。(大卫亚设,Northern Exposure)。

一般来说,要准确翻译照片中的文字,至少需要3种能力3360

阶段:火眼金睛,“看得清楚”。

照片翻译首先测试OCR功能,而不是NLP技术,以满足用户的需求。只有识别正确,才能为后续翻译奠定基础。这种能力的核心评价指标就是字准率。

运营上,Apple iOS15采用内置方式,可以直接从照片中选择要翻译的文本来查看翻译结果。适当的词典应该在应用程序中打开照片识别功能。前者在使用上应该更方便一些。但是到了识别链接,iOS15拉了一下胯部。

我们找到了一个英语短文、一个英语长句和一个汉语长句。结果显示,在英语自准率上,苹果和适当的差异不大。

例如,可以识别“Do me a favor,can you look for my credit card . I don ' t find it”的原文

IOS15的结果是:Do me a favor。can you look for my credit card,I don find it。

苹果将don't识别为don,但对阅读没有太大影响,准确度仍然可以接受。

请换个英语长句测试一下。下面这张照片,适当的识别结果是:

one bad chapter doesn ' t mean my story is over until you find a new chapter which you think it ' s right达到了98.96%的自给率。

IOS15的结果是:

one bad chapter t mean my story is over until you find chapter which you think it ' l s right .

将It's right识别为IT ' l Right可能会影响后续语义的理解。

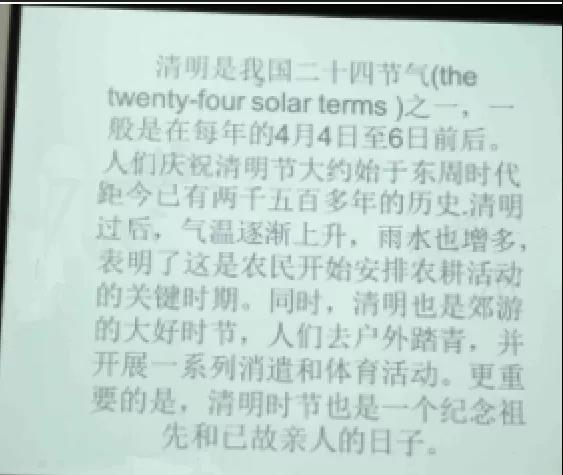

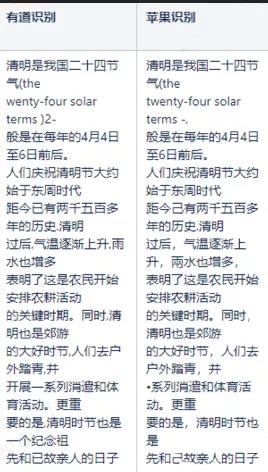

到了中文准考证,讲道理和苹果拉开了差距。例如,下图:

完全认识,苹果iOS15没有认识到“雨”的雨,“系列”,倒数第二段的“纪念组”一词也被漏掉,直接影响了阅读体验和用户理解。

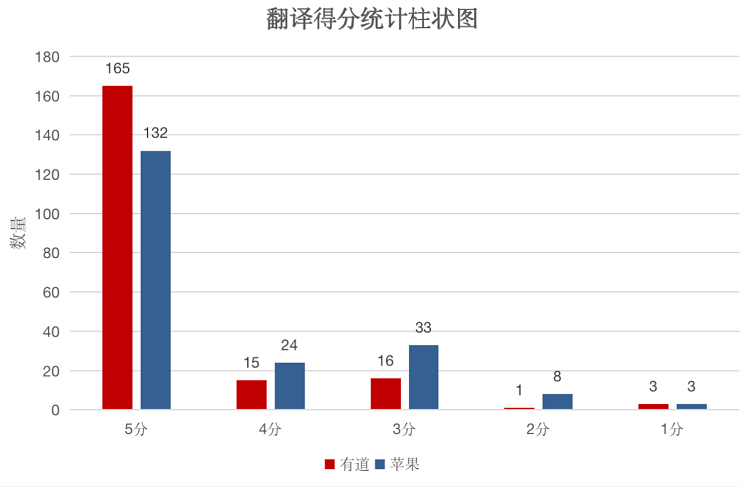

综合来说,英语自准率两者差异不大,略胜一筹。(威廉莎士比亚、温斯顿、英语名言)有办法在中文水平上做到90%以上的正确认识,苹果iOS15只有79%,优势明显。

这种差距的原因似乎是图片翻译中积累了更多的词典。

从5年前开始尝试开发照片翻译功能,接着通过现货云向很多主要手机企业提供相关功能。很多用户积累了教育资料,以用于各种照明条件、各种用途。通过持续重复段落分析、图片检测、图像偏移角度检测、语言检测等算法,OCR能力自然可以针对用途进行优化。(约翰肯尼迪,作家)。

而且,作为中国公司,对汉语母语的理解更深,苹果iOS15刚刚开始普及,现实场景中的汉语识别还不够,这也是可以理解的。(大卫亚设,中文)。

第二阶段:心像镜子一样“可以理解”。

图片文本识别完成后,需要神经机器翻译。中文和英文都是语料比较丰富的语言,所以对其理解能力的要求也更高。

所以我们选择了两个细节来调查:

,时态。

原文包含“是的,今天出去玩”的计划意思。

“是的。必须翻译成“we're going out today”。

苹果的翻译是:Yes.go out today。

显然,在采用“be going”的一般未来时,更准确地理解原文的意图,表达计划、准备、做某事的意思,苹果的译文没有反映出计划的状态。(威廉莎士比亚,《北方执行》(Northern Exposure))。

第二个是单数。

英语单词的单复数往往承担着截然不同的解释,如果不能正确识别,译文可能会与原意相反。

例如,这个“1200square”被翻译成“1200平方”,苹果iOS15的翻译被翻译成“1200广场”。

Square是指单数状态下的平方单位,苹果的翻译容易使读者模糊。

当然,在整体理解中,与苹果的中英翻译水平一起,可以满足基本的阅读需求。

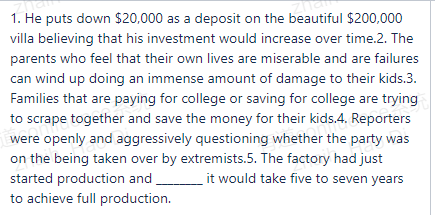

例如,这个长句子3360

He puts down $20,000 a s a deposit on the beautiful $ 200,000 villa believing that his investment would increase over time。

适当的译文3360他为价值20万美元的漂亮别墅支付了2万美元的定金,相信他的投资会随着时间的推移而增加。

IOS15的译文3360他用这座美丽的20万美元别墅的保证金存了2万美元,相信他的投资会随着时间的推移而增加。

目前,照片翻译的中文相互翻译、适当的方法和iOS15基本上表现出了强大的理解能力。部分单词的用法、表达习惯上的细节洞察有差异,其背后是语料积累、型号选择、性能优化等差异。

第三阶段:雪莲,“说别人的话”。

中文翻译,很多人的黄金指标是“辛达雅”。也就是说,译文要准确,不要偏离原文。要乖乖,语法结构符合习惯。优雅,用语精通,文采丰富。

神经机器翻译发展到今天,能满足这个要求吗?具有不同语言基因的两个翻译平台苹果和苹果只能调戏一次。

请先发一次:分钟

原文:你们收了我80元

译文:You charged me580

IOS15翻译3360You received me80yuan。

“得到钱”是charge,翻译更符合英语表达,苹果直接把“得到”翻译成“receive”并不精通。

请再尝试一个中间长的句子。

原文:After the accident,I felt myself another person。

译文:事故发生后,我觉得我变成了一个人。

IOS15译文3360事故发生后,我感到我是别人。

苹果公司将“another person”直接翻译成“别人”,不表达内心的变化,容易产生歧义,翻译成“一个人”,使其更加准确口语化。

当然,也可能存在太直译的问题。例如,下图中原文为:In conclusion,drawing on the electronic media or printed books might be a good approach to understand different places or count

翻译成:使用电子媒体或印刷的书可能是了解其他地区或的好方法。

苹果翻译成:总之,利用电子媒体或印刷的书可能是了解其他地区或的好方法。

IOS15在调整词序后,表达更加恰当自然,有时会根据该模式直译。

但是此次考试问题主要以生活、旅游、文化交流场面为基础进行,对专有名词的翻译效果有待进一步考察。

另外,由于Apple iOS15在阶段OCR识别中的自准率较低,直接影响后续文本的理解,因此Apple的一些翻译结果数据没有参考性,因此无法对翻译水平做出结论。

一次辛达雅的照片翻译是多技术的融合,可以看到OCR、分词、理解意思、记忆上下文、提取主题等多种能力共同工作。

因此,初生苹果系统级照片翻译要代替专业翻译软件还有很长的路要走。但是,作为专业翻译软件,关于机器翻译的普遍问题也可以继续加强专业壁垒。(威廉莎士比亚,《北方执行》(Northern Exposure))。

这也引起了我们的思考,为什么有了AI,神经机器翻译仍然比不上人类翻译者?(另一方面)。

理想和现实的锯齿状:

戴着镣铐跳舞的神经机器翻译

神经网络引入机器翻译时,被认为是的神器。但是几年后的现在,这种神奇的技术比传统的统计机器翻译要得多,但与人类翻译家的水平相去甚远。

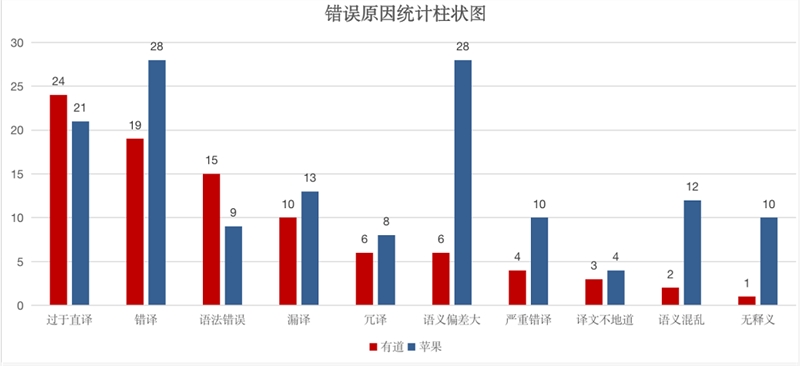

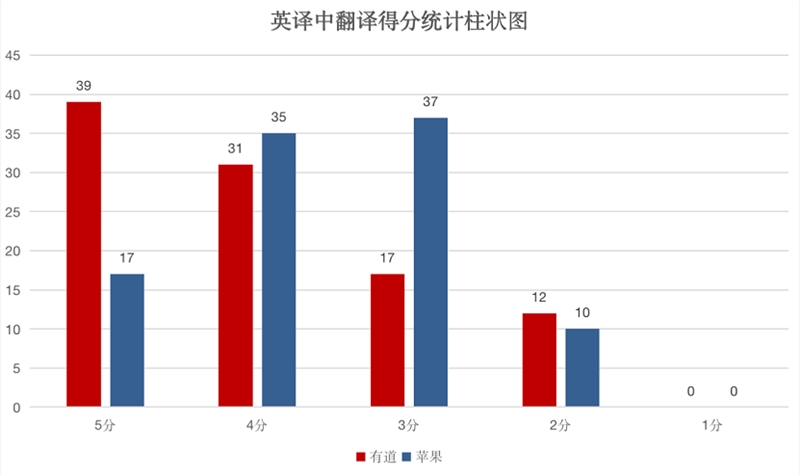

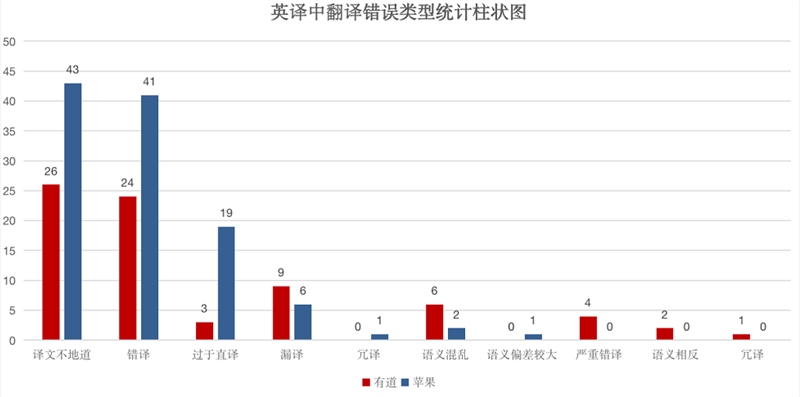

从此次苹果iOS15和有适当词典的横向评价来看,两者都存在一定的不足之处。简而言之,原因可以是很多方面的3360

1.Out of Vocabulary(OOV)问题很难解决。

基于深度神经网络的机器翻译模型需要大量的数据学习。数据量小会降低出现次数少的单词的单词矢量质量,实际应用程序中未注册的单词太多,可能会发生误译、误译等。目前,一些垂直领域资料不足,语料不足,特别是汉语中有数千个文字,其中很多文字是生僻的文字,影响模型表达和译文的质量。

为了解决这一点,只能用“愚蠢的功夫”积累数据。据有词典的技术人员说,学好汉语没有特别好的方法,不断积累数据,反复算法,在过去几年里做了很多工作。

算法优化和创新正在等待突破。

语言文化不同,文字表达、逻辑结构、信息重复度、语法结构不同,“信息不对称”很多,难怪在“编解码器”过程中会出现误译。

《文化翻译论纲》一本书提到,译文是“原文化背景译文文化背景原著家的气质和风格翻译家的气质和风格”的混合体。

要想理解背后的文化、气质、风格等“隐藏属性”,只能通过技术重复和创新来实现。例如,有一种方法可以让用户提供额外的用户指定词典,准确地调整神经网络机器翻译的部分结果,并解决专有名词的翻译问题。

业界也开始引入多模态翻译,通过图中其他事物的特点帮助理解文本。例如,如果机器翻译只看到GATE这个词,就可以简单地翻译成“门”,但如果照片上的机票或背景是机场,那么翻译成“登机口”就更合适了。

3.没有细分场景拟合的捷径。

随着机器翻译的普及,用户对翻译质量提出了更详细的要求,例如翻译照片时前面的少量识别错误可能导致的级联问题。网页翻译不仅要提供准确的翻译,还要保持原始网页风格的一致性。文档翻译时,名称、地名、组织名称或专业术语可能会出现多次,上下文如何匹配?即使在配置较低的终端设备上,也必须提供快速好的翻译体验。各种方案中的各种问题需要针对用途进行优化。(约翰肯尼迪,作家)。

照片翻译的话,自然场景下的图像识别非常复杂,经常在实验室里效果非常好,但用户要在各种照明条件下拍摄各种奇怪的东西,识别后判断哪些单词属于一个句子,哪些句子是一个段落,翻译结果应该如何出现。据悉,它还经过了长时间的优化,算法方面的翻译模型得到了稳固和改进,即使在实际环境中出现了个别不可避免的字符识别错误,它仍然具有稳定的性能。

从这个角度来看,照片翻译等新的应用场景试图给用户带来经验的颠覆性变化,不仅是实验室的革新,还集中解决技术在应用场景中遇到的具体问题,从而优化最终体验没有捷径。(阿尔伯特爱因斯坦,北方执行)。

从被人类翻译家抢饭碗的“巫术”到学习娱乐场场景中经常出没的日常应用程序,神经机器翻译技术落地的速度超出了很多人的想象。

在这些实用技术上,应用突破比理论突破更简单更紧迫。这也是我们现在想谈论照片翻译这个“小”功能的原因。

随着全球交流的逐步恢复,越来越不可避免地需要更自然、实时地理解跨语言信息。照片翻译对旅行、专业阅读、无障碍人触网等具有不可缺少的价值。这也是苹果、适当方法等产业界力量的价值。通过来自实际环境的数据、交互和反馈,不断推进神经机器翻译的小发展。

目前,苹果iOS15的系统级照片翻译取代专业翻译软件还为时尚早。事实上,未来不会相互替代,而是以各自适用的场景和需求强度相互补充,发挥各自的优势。

来自产业界的所有实践都使技术更上一层楼。弥撒城塔总有可以越过妨碍语言交流的“通天塔”。

-

24

2023-02

-

30

2022-11

-

23

2022-11

-

23

2022-11

-

17

2022-11

-

08

2022-11

- 世纪互联蓝云成为中国首批微软互联网汽车平台合作伙伴

- 招联好贷带你了解短信钓鱼诈骗 保护你的资金

- 小米11电缆充电慢吗?MIUI发布:本月已优化充电政策进行维修

- 2021电视机顶盒哪个好?老牛磊吐血整理的话 一定要买单子!

- 蔚来:通过新品牌进入大众市场

- 微博视频奖励功能测试只对部分受邀博主开放

- 百度文库回应说 店铺销售别人的论文 已经离线文件和永奉店铺

- 立陶宛称小米手机内置审查?小米:遵守欧盟通用数据保护条例

- 苹果商店应用程序价格具体受税率或外汇汇率的影响

- 作者最新文章

- 英特尔Alder Lake台式处理器跑分超越M1 Max 但输在能效比

- 百度为ICML、IJCAI、ISIT等选择的论文有哪些

- 3条杜石川胖鲤鱼在憨态可掬地出游网友神游 减肥没有用

- 拜登政府提出新规则:航空公司将不得不为损坏的无线网络提供退款

- 今年双11 你被“种草”了吗?

- 2015年7月24日凌晨零点,NASA宣布发现系外行星,NASA捕捉到“太阳的微笑”:专家警告预示地磁暴将袭击地球 遇黑暗时刻

- 麒麟985 5G还能打华为nova 8/9等四款测试鸿蒙系统3.0

- 外卖 takeout:外卖在Tik Tok 前途光明 困难重重

- 本地宝-全国核酸检测查询器:高德、百度和腾讯的“核酸检测地图”上线了!98个一键查询!

- 谷歌多名资深“开源大佬”被裁;黑客窃取GitHub的代码签名证书|思考周刊